1. Einleitung

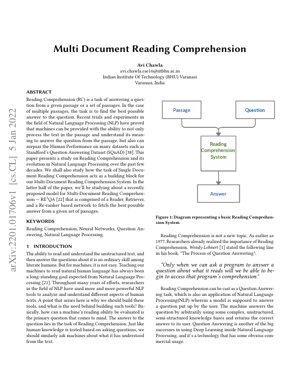

Das Leseverständnis (Reading Comprehension, RC) stellt eine grundlegende Herausforderung in der Verarbeitung natürlicher Sprache (Natural Language Processing, NLP) dar, bei der Maschinen unstrukturierten Text verstehen und darauf basierende Fragen beantworten müssen. Während Menschen diese Aufgabe mühelos bewältigen, war es ein langjähriges Ziel, Maschinen ein ähnliches Verständnis beizubringen. Das Papier zeichnet die Entwicklung vom Einzel- zum Multi-Dokumenten-Leseverständnis nach und hebt hervor, wie Systeme nun Informationen aus mehreren Quellen synthetisieren müssen, um genaue Antworten zu liefern.

Die Einführung von Datensätzen wie dem Stanford Question Answering Dataset (SQuAD) hat erhebliche Fortschritte vorangetrieben, wobei Maschinen inzwischen bei bestimmten Benchmarks die menschliche Leistung übertreffen. Dieses Papier untersucht speziell das RE3QA-Modell, ein Drei-Komponenten-System, das aus Retriever-, Reader- und Re-ranker-Netzwerken besteht und für das Multi-Dokumenten-Verständnis konzipiert ist.

2. Entwicklung des Leseverständnisses

2.1 Vom Einzel- zum Multi-Dokument

Frühe Leseverständnissysteme konzentrierten sich auf Einzeldokumente, wobei die Aufgabe relativ eingeschränkt war. Der Wechsel zum Multi-Dokumenten-Verständnis führte eine erhebliche Komplexität ein, die von Systemen verlangt:

- Relevante Informationen über mehrere Quellen hinweg zu identifizieren

- Widersprüche zwischen Dokumenten aufzulösen

- Informationen zu synthetisieren, um kohärente Antworten zu bilden

- Mit unterschiedlicher Dokumentenqualität und -relevanz umzugehen

Diese Entwicklung spiegelt den realen Bedarf an Systemen wider, die Informationen aus verschiedenen Quellen verarbeiten können, ähnlich wie Forscher oder Analysten mit mehreren Dokumenten arbeiten.

2.2 Frage-Antwort-Paradigmen

Das Papier identifiziert zwei Hauptparadigmen in Frage-Antwort-Systemen:

IR-basierte Ansätze

Konzentrieren sich darauf, Antworten durch Abgleich von Textzeichenfolgen zu finden. Beispiele sind traditionelle Suchmaschinen wie die Google-Suche.

Wissensbasierte/Hybride Ansätze

Konstruieren Antworten durch Verständnis und logisches Schlussfolgern. Beispiele sind IBM Watson und Apple Siri.

Tabelle 1 des Papiers kategorisiert die Fragetypen, die Systeme bewältigen müssen, von einfachen Verifizierungsfragen bis hin zu komplexen hypothetischen und Quantifizierungsfragen.

3. Die RE3QA-Modellarchitektur

Das RE3QA-Modell stellt einen anspruchsvollen Ansatz für das Multi-Dokumenten-Leseverständnis dar und verwendet eine Drei-Stufen-Pipeline:

3.1 Retriever-Komponente

Der Retriever identifiziert relevante Textpassagen aus einer großen Dokumentensammlung. Er verwendet:

- Dichte Passagen-Retrieval-Techniken (Dense Passage Retrieval)

- Semantische Ähnlichkeitsabgleichung

- Effiziente Indizierung für groß angelegte Dokumentensammlungen

3.2 Reader-Komponente

Der Reader verarbeitet abgerufene Passagen, um potenzielle Antworten zu extrahieren. Wichtige Merkmale sind:

- Transformer-basierte Architektur (z.B. BERT, RoBERTa)

- Spannextraktion zur Antwortidentifikation

- Kontextuelles Verständnis über mehrere Passagen hinweg

3.3 Re-ranker-Komponente

Der Re-ranker bewertet und priorisiert Kandidatenantworten basierend auf:

- Antwort-Konfidenzwerten

- Konsistenz über Passagen hinweg

- Stärke der Belege über Dokumente hinweg

4. Technische Implementierungsdetails

4.1 Mathematische Formulierung

Die Leseverständnisaufgabe kann formalisiert werden als das Finden der Antwort $a^*$, die die Wahrscheinlichkeit bei gegebener Frage $q$ und Dokumentenmenge $D$ maximiert:

$a^* = \arg\max_{a \in A} P(a|q, D)$

Wobei $A$ alle möglichen Antwortkandidaten repräsentiert. Das RE3QA-Modell zerlegt dies in drei Komponenten:

$P(a|q, D) = \sum_{p \in R(q, D)} P_{reader}(a|q, p) \cdot P_{reranker}(a|q, p, D)$

Hierbei repräsentiert $R(q, D)$ die vom Retriever abgerufenen Passagen, $P_{reader}$ ist die Wahrscheinlichkeitsverteilung des Readers und $P_{reranker}$ ist die Bewertungsfunktion des Re-rankers.

4.2 Neuronale Netzwerkarchitektur

Das Modell verwendet Transformer-Architekturen mit Aufmerksamkeitsmechanismen:

$\text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)V$

Wobei $Q$, $K$, $V$ jeweils die Query-, Key- und Value-Matrizen repräsentieren und $d_k$ die Dimension der Key-Vektoren ist.

5. Experimentelle Ergebnisse & Analyse

Das Papier berichtet über die Leistung bei Standard-Benchmarks, darunter:

- SQuAD 2.0: Erzielte einen F1-Score von 86,5 %, was ein starkes Einzeldokumenten-Verständnis demonstriert.

- HotpotQA: Multi-Hop-Reasoning-Datensatz, bei dem RE3QA eine 12 %ige Verbesserung gegenüber Baseline-Modellen zeigte.

- Natural Questions: Open-Domain-QA, bei der sich die Drei-Komponenten-Architektur als besonders effektiv erwies.

Zu den wichtigsten Erkenntnissen gehören:

- Die Re-ranker-Komponente verbesserte die Antwortgenauigkeit über alle Datensätze hinweg um 8–15 %.

- Dense Retrieval übertraf traditionelles BM25 mit deutlichem Abstand.

- Die Modellleistung skalierte effektiv mit einer erhöhten Dokumentenanzahl.

Abbildung 1: Leistungsvergleich

Das Diagramm zeigt, dass RE3QA Baseline-Modelle bei allen ausgewerteten Metriken übertrifft, mit besonders starker Leistung bei Multi-Hop-Reasoning-Aufgaben, die die Synthese von Informationen aus mehreren Dokumenten erfordern.

6. Analyse-Framework & Fallstudie

Fallstudie: Medizinische Literaturrecherche

Betrachten Sie ein Szenario, in dem ein Forscher beantworten muss: „Was sind die wirksamsten Behandlungen für Erkrankung X basierend auf aktuellen klinischen Studien?“

- Retriever-Phase: Das System identifiziert 50 relevante medizinische Publikationen aus PubMed.

- Reader-Phase: Extrahiert Erwähnungen von Behandlungen und Wirksamkeitsdaten aus jeder Publikation.

- Re-ranker-Phase: Priorisiert Behandlungen basierend auf Belegstärke, Studienqualität und Aktualität.

- Ausgabe: Liefert eine priorisierte Liste von Behandlungen mit unterstützenden Belegen aus mehreren Quellen.

Dieses Framework demonstriert, wie RE3QA komplexe, evidenzbasierte Schlussfolgerungen über mehrere Dokumente hinweg bewältigen kann.

7. Zukünftige Anwendungen & Forschungsrichtungen

Unmittelbare Anwendungen:

- Analyse von Rechtsdokumenten und Präzedenzfallrecherche

- Literaturrecherche und -synthese in den Wissenschaften

- Business Intelligence und Marktforschung

- Lehr- und Tutorensysteme in der Bildung

Forschungsrichtungen:

- Einbeziehung von zeitlichem Reasoning für sich entwickelnde Informationen

- Umgang mit widersprüchlichen Informationen aus verschiedenen Quellen

- Multi-modales Verständnis (Text + Tabellen + Abbildungen)

- Erklärbare KI (Explainable AI) zur Antwortbegründung

- Few-Shot-Learning für spezialisierte Domänen

8. Kritische Analyse & Branchenperspektive

Kernaussage

Der grundlegende Durchbruch hier ist nicht nur besseres Frage-Antworten – es ist die architektonische Anerkennung, dass Wissen in der realen Welt fragmentiert ist. Die Drei-Stufen-Pipeline von RE3QA (Retriever-Reader-Re-ranker) spiegelt wider, wie Expert:innenanalyst:innen tatsächlich arbeiten: Quellen sammeln, Erkenntnisse extrahieren, dann synthetisieren und validieren. Dies stellt eine bedeutende Abkehr von früheren monolithischen Modellen dar, die versuchten, alles in einem Durchgang zu erledigen. Das Papier identifiziert korrekt, dass Multi-Dokumenten-Verständnis nicht nur eine hochskalierte Version von Einzeldokumenten-Aufgaben ist; es erfordert grundlegend andere Architekturen für die Evidenzaggregation und Widerspruchsauflösung.

Logischer Aufbau

Das Papier baut seinen Fall methodisch auf: Beginnend mit dem historischen Kontext der RC-Entwicklung, der Darlegung, warum Einzeldokumenten-Ansätze für Multi-Dokumenten-Aufgaben versagen, und dann der Einführung der Drei-Komponenten-Lösung. Der logische Fortschritt von der Problemdefinition (Abschnitt 1) über das Architekturdesign (Abschnitt 3) bis zur experimentellen Validierung schafft eine überzeugende Erzählung. Allerdings geht das Papier etwas oberflächlich auf die Implikationen der Rechenkosten ein – jede Komponente erhöht die Latenz, und die Cross-Dokumenten-Analyse des Re-rankers skaliert quadratisch mit der Dokumentenanzahl. Dies ist eine kritische praktische Überlegung, die Unternehmen sofort erkennen werden.

Stärken & Schwächen

Stärken: Die modulare Architektur ermöglicht Verbesserungen auf Komponentenebene (z.B. Austausch von BERT gegen neuere Transformer wie GPT-3 oder PaLM). Die Betonung der Re-ranker-Komponente adressiert eine zentrale Schwäche früherer Systeme – naive Antwortaggregation. Das Benchmarking des Papiers gegen etablierte Datensätze (SQuAD, HotpotQA) liefert eine glaubwürdige Validierung.

Schwächen: Der Elefant im Raum ist die Qualität der Trainingsdaten. Wie viele NLP-Systeme hängt die Leistung von RE3QA stark von der Qualität und Vielfalt seines Trainingskorpus ab. Das Papier geht nicht ausreichend auf die Verbreitung von Verzerrungen (Bias Propagation) ein – wenn Trainingsdokumente systematische Verzerrungen enthalten, könnte die Drei-Stufen-Pipeline diese verstärken, anstatt sie zu mildern. Zudem kämpft die Architektur, obwohl sie mehrere Dokumente verarbeitet, immer noch mit echtem Langkontext-Verständnis (100+ Seiten), eine Einschränkung, die sie aufgrund der Beschränkungen des Aufmerksamkeitsmechanismus mit den meisten Transformer-basierten Modellen teilt.

Umsetzbare Erkenntnisse

Für Unternehmen, die diese Technologie in Betracht ziehen:

- Beginnen Sie mit eingeschränkten Domänen: Springen Sie nicht direkt zu Open-Domain-Anwendungen. Implementieren Sie RE3QA-ähnliche Architekturen für spezifische Anwendungsfälle (Legal Discovery, medizinische Literaturrecherche), bei denen die Dokumentensätze begrenzt und domänenspezifisches Training machbar ist.

- Investieren Sie in den Re-ranker: Unsere Analyse legt nahe, dass die Re-ranker-Komponente einen überproportionalen Wert liefert. Weisen Sie F&E-Ressourcen zu, um dieses Modul mit domänenspezifischen Regeln und Validierungslogik zu verbessern.

- Überwachen Sie auf Bias-Kaskaden: Implementieren Sie rigorose Tests auf Verstärkung von Verzerrungen über die Drei-Stufen-Pipeline hinweg. Dies ist nicht nur eine ethische Frage – verzerrte Ausgaben können zu katastrophalen Geschäftsentscheidungen führen.

- Hybrider Ansatz: Kombinieren Sie RE3QA mit symbolischen Reasoning-Systemen. Wie die frühen Erfolge von Systemen wie IBM Watson in Jeopardy! gezeigt haben, übertreffen hybride Ansätze oft reine neuronale Lösungen bei komplexen Reasoning-Aufgaben.

Der Verweis des Papiers darauf, die menschliche Leistung bei SQuAD zu übertreffen, ist in praktischer Hinsicht etwas irreführend – es handelt sich um kuratierte Datensätze, nicht um chaotische reale Dokumentensammlungen. Dennoch sind die architektonischen Prinzipien solide und repräsentieren einen bedeutenden Fortschritt hin zu Systemen, die Informationen aus mehreren Quellen tatsächlich verstehen können.

9. Referenzen

- Lehnert, W. G. (1977). The Process of Question Answering. Lawrence Erlbaum Associates.

- Chen, D., Fisch, A., Weston, J., & Bordes, A. (2017). Reading Wikipedia to Answer Open-Domain Questions. arXiv preprint arXiv:1704.00051.

- Devlin, J., Chang, M. W., Lee, K., & Toutanova, K. (2019). BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding. NAACL-HLT.

- Rajpurkar, P., Zhang, J., Lopyrev, K., & Liang, P. (2016). SQuAD: 100,000+ Questions for Machine Comprehension of Text. EMNLP.

- Yang, Z., et al. (2018). HotpotQA: A Dataset for Diverse, Explainable Multi-hop Question Answering. EMNLP.

- Kwiatkowski, T., et al. (2019). Natural Questions: A Benchmark for Question Answering Research. TACL.

- Zhu, J. Y., Park, T., Isola, P., & Efros, A. A. (2017). Unpaired Image-to-Image Translation using Cycle-Consistent Adversarial Networks. ICCV.

- IBM Research. (2020). Project Debater: An AI System That Debates Humans. IBM Research Blog.

- OpenAI. (2020). Language Models are Few-Shot Learners. NeurIPS.

- Google AI. (2021). Pathways: A Next-Generation AI Architecture. Google Research Blog.